La inteligencia artificial está aquí y está haciendo películas. ¿Está Hollywood preparado?

Scott Mann tenía un problema: demasiadas malas palabras.

El guionista y director había concluido la producción de “Fall”, su thriller sobre unos escaladores atrapados en lo alto de una remota torre de televisión, donde animaba a los dos protagonistas a realizar diálogos divertidos. Esa improvisación dio lugar a la friolera de 35 “f-cks” en la película, situándola firmemente en territorio de clasificación R.

Pero cuando Lionsgate firmó para distribuir “Fall”, el estudio quería una edición para mayores de 13 años. “Desinfectar” la película significaría eliminar todas las obscenidades menos una.

“¿Cómo se resuelve eso? recuerda Mann desde la sala de conferencias acristalada de su oficina de Santa Mónica este octubre, dos meses después del estreno de la película. Un buitre de atrezzo que se había llevado del plató estaba posado en el vestíbulo.

Después de todo, los nuevos rodajes son caros y requieren mucho tiempo. Mann había rodado “Fall” en la cima de una montaña, explicó, y había tenido que luchar no sólo contra el COVID, sino también contra huracanes y tormentas eléctricas. En un momento dado, una colonia de hormigas rojas se instaló en el set principal de la película, un tubo metálico de 30 metros de largo; cuando el equipo las trato de alejar, el enjambre envolvió el decorado “como una nube”.

“Fall ha sido probablemente la película más difícil que he hecho nunca”, afirma Mann. ¿Podría evitar volver a hacerla?

La solución, se dio cuenta, podría ser un proyecto que había estado desarrollando al mismo tiempo que la película: un software de inteligencia artificial que pudiera editar las imágenes de los rostros de los actores mucho después de haber terminado la fotografía principal, modificando a la perfección sus expresiones faciales y los movimientos de la boca para que coincidieran con los diálogos recién grabados.

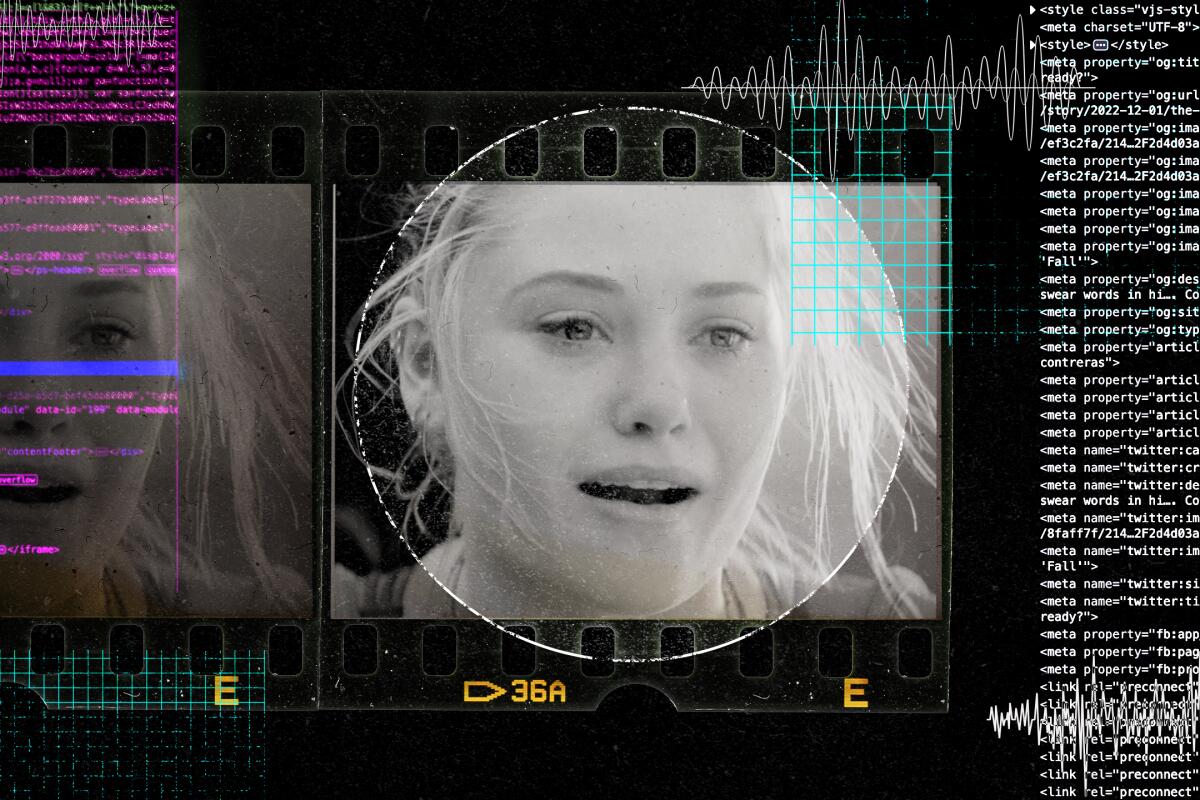

“Fall” was edited in part using software developed by director Scott Mann’s artificial intelligence company Flawless.(Courtesy of Flawless)

Es un uso aparentemente sencillo para una tecnología que, según los expertos, está a punto de transformar casi todas las dimensiones de Hollywood, desde la dinámica laboral y los modelos financieros hasta la forma en que el público piensa sobre lo que es real o falso.

La inteligencia artificial hará con las imágenes en movimiento lo que Photoshop hizo con las fijas, afirma en un correo electrónico Robert Wahl, profesor asociado de informática de la Universidad Concordia de Wisconsin, que ha escrito sobre la ética de la CGI. “Ya no podemos confiar plenamente en lo que vemos”.

Una solución informática para doblajes dudosos

Fue necesaria una colaboración especialmente desalentadora con Robert De Niro para empujar a Mann al mundo del software.

De Niro protagonizaba “Atraco”, el thriller policíaco de Mann de 2015, y ambos habían dedicado mucho tiempo y reflexión a la interpretación del aclamado actor. Pero cuando llegó el momento de adaptar la película para estrenarla en el extranjero, Mann no quedó satisfecho.

Cuando las películas se estrenan en el extranjero, los diálogos se suelen regrabar en otros idiomas. Ese proceso, llamado “doblaje”, hace que la película sea accesible internacionalmente, pero también puede provocar la imagen desagradable de la boca de un actor moviéndose fuera de sincronía con las palabras que supuestamente está diciendo. Una solución habitual es reescribir los diálogos para que encajen mejor con los elementos visuales preexistentes, pero, en aras de la legibilidad, esos cambios sacrifican la visión original del equipo creativo.

“Todas las cosas que había trabajado en meticulosos matices con Robert De Niro ahora estaban cambiados”, dijo Mann sobre los doblajes. “Estaba desolado”.

Una película posterior en la que trabajó, “Final Score”, profundizó esas frustraciones. Mann intentó escanear las cabezas de los actores para sincronizar mejor su voz, pero el proceso resultó prohibitivo y el resultado final era extraño.

El entusiasta de los efectos visuales encontró un artículo académico de 2018 que esbozaba una posible solución: redes neuronales, o programas informáticos que imitan la estructura de un cerebro, que intentaban transponer la expresión facial de un actor a la cara de otro.

Fascinado, Mann se puso en contacto con los autores del artículo y empezó a colaborar con algunos de ellos en una herramienta rudimentaria de “doblaje”, es decir, de doblaje visual en lugar de sonoro. La posterior incorporación de Nick Lynes, un amigo de un amigo con experiencia en juegos en línea, dio al equipo un punto de apoyo en el sector tecnológico.

Juntos, los enviados de tres mundos muy diferentes -el cine, la ciencia y la industria del software- construyeron Flawless, una empresa de cine de inteligencia artificial con oficinas en Santa Mónica y Londres.

En términos muy generales, la tecnología de la empresa puede identificar patrones en los fonemas (los sonidos que emiten) y visemas (el aspecto que tienen cuando emiten esos sonidos) de un actor y, cuando se le presentan nuevos fonemas grabados, actualizar los visemas en pantalla para que coincidan. El año pasado, la revista Time consideró el “remedio para el doblaje de películas” de la empresa uno de los mejores inventos de 2021.

Sin embargo, la lucha por eliminar docenas de palabrotas de “Fall” planteó una cuestión con ramificaciones potencialmente mucho más amplias: en lugar de limitarse a cambiar el idioma en que hablan los personajes, ¿podría Flawless alterar el contenido mismo de lo que dicen?

“Fuimos a un estudio de grabación en Burbank con las actrices y les dijimos: ‘Muy bien, estas son las nuevas frases’”, explica Mann, que vive en Los Ángeles. Luego introdujeron el nuevo audio en el software de doblaje, que ajustó en consecuencia los movimientos faciales de las estrellas en pantalla.

“Pusimos las tomas, la MPAA volvió a revisarla y le dio PG-13, y eso fue lo que llegó a los cines”, dijo.

Sentado en su sala de conferencias de Santa Mónica varias semanas después del estreno de la película, rodeado de carteles de “Blade Runner” y “2001: Odisea del espacio”, Mann mostró los resultados con una escena en la que uno de los protagonistas de “Fall” se lamenta de su situación.

“Ahora estamos atrapados en esta estúpida torre en medio de la nada”, exclamó Virginia Gardner a Grace Caroline Currey mientras ambas se acurrucaban en lo alto de una plataforma precariamente elevada.

Un momento después, Mann repitió la escena. Pero esta vez, el diálogo de Gardner era notablemente más duro: “Ahora estamos atrapados en esta jodida torre en medio de la nada”.

La primera versión fue la que se estrenó en agosto en más de 1.500 cines estadounidenses. Pero la segunda -la que tiene diálogos dignos de un marinero- fue la que Mann rodó en aquella cima infestada de hormigas rojas. Si no supieras que una red neuronal ha reconstruido los rostros de los actores, probablemente no tendrías ni idea de que el diálogo fue un añadido tiempo después.

“No puedes distinguir lo que es real de lo que no lo es”, dice Mann, “eso es de lo que se trata”.

La ética de lo sintético

Cuando se trata de hacer cine, ese realismo tiene ventajas evidentes. Nadie quiere gastarse dinero en algo que parece salido de MS Paint.

Pero el auge de los programas informáticos capaces de cambiar a la perfección lo que alguien parece haber dicho tiene importantes implicaciones para un entorno mediático ya inundado de desinformación. Al fin y al cabo, el producto principal de Flawless no es más que una versión más legítima de los “deep-fakes” o CGI que imitan la cara y la voz de alguien.

No es difícil imaginar a un troll que, en lugar de utilizar estas herramientas para cortar palabrotas de una película, haga un vídeo viral de Joe Biden declarando la guerra a Rusia. El porno hecho con la imagen digital de alguien también se ha convertido en un problema.

Y Flawless no es la única empresa que trabaja en este espacio. Papercup, una empresa que genera voces humanas sintéticas para doblajes y locuciones, pretende “hacer que cualquier vídeo se pueda ver en cualquier idioma”, declaró a The Times su director ejecutivo, Jesse Shemen.

Y el pilar de los efectos visuales, Digital Domain, utiliza el aprendizaje automático para representar a los actores en casos en los que no pueden aparecer ellos mismos, como las escenas que requieren un doble de acción, dijo el director de tecnología Hanno Basse.

A medida que estas y otras empresas automatizan cada vez más la industria del entretenimiento, surgen cuestiones éticas.

Hollywood ya se está enfrentando a su nueva capacidad para recrear digitalmente a actores muertos, como ocurrió con la voz de Anthony Bourdain en el documental “Roadrunner” o con Peter Cushing y Carrie Fisher en las recientes secuelas de “La guerra de las galaxias”. Ahora también es posible revivir holográficamente a celebridades fallecidas.

Los diálogos alterados digitalmente “corren el riesgo de comprometer el consentimiento de los que participaron originalmente”, dijo Scott Stroud, director del programa de ética de los medios de comunicación de la Universidad de Texas en Austin. “Lo que los actores pensaban que estaban aceptando no es literalmente lo que se está creando”.

Y esta tecnología podría abrir la puerta a que las películas se modifiquen mucho después de su estreno, dijo Denver D’Rozario, profesor de marketing de la Universidad Howard que ha estudiado la resurrección por software de actores muertos.

“Digamos... que en una película un tipo está bebiendo una lata de Pepsi, y dentro de 20 años consigues un patrocinio de Coca-Cola”, dijo D’Rozario. “¿Cambias la lata de Pepsi por la de Coca-Cola?”. “¿En qué momento se pueden cambiar las cosas? ¿En qué momento se pueden comprar las cosas?”.

Mann dice que las ventajas de su tecnología son muchas, desde derribar las barreras lingüísticas y fomentar la empatía transfronteriza hasta ahorrar a los actores el dolor de cabeza de los nuevos rodajes. En su opinión, escenarios como el hipotético patrocinio de Coca-Cola por D’Rozario representan nuevas fuentes de ingresos.

Flawless ha sido proactiva, añadió Mann, a la hora de construir un producto que ayude en lugar de suplantar el auténtico talento humano.

“Hay una forma de utilizar las tecnologías de una manera similar a la que ya ha establecido la industria [de los efectos visuales], que es como: hacerlo de forma segura, hacerlo bien, hacerlo legalmente, con el consentimiento de todos los implicados”, dijo.

El director añadió que la empresa ya ha consultado a “todos los grandes sindicatos” sobre cómo crear y utilizar esta tecnología de forma sensata.

Los representantes de SAG-AFTRA subrayaron que la tecnología de la inteligencia artificial puede ayudar o perjudicar a los actores, dependiendo de cómo se utilice.

“Las tecnologías que no hacen más que mejorar digitalmente el trabajo de nuestros miembros pueden requerir la capacidad de proporcionar un consentimiento informado y, posiblemente, una compensación adicional”, dijo Jeffrey Bennett, consejero general de SAG-AFTRA, en un correo electrónico. “En el otro extremo del espectro están las tecnologías que podrían sustituir a la actuación tradicional o que toman las actuaciones de nuestros miembros y crean otras totalmente nuevas; para éstas, mantenemos que son un tema obligatorio de negociación”.

Es un tren que, para bien o para mal, ya ha salido de la estación.

“Fall” se está emitiendo actualmente, y Mann dijo que otras películas en las que trabajó su empresa se estrenarán esta Navidad, aunque todavía no puede nombrarlas públicamente.

Si ves una película durante las fiestas, es posible que una inteligencia artificial haya ayudado a crearla.

¿Podrás saberlo? ¿Importaría?

Para leer esta nota en inglés haga clic aquí

Suscríbase al Kiosco Digital

Encuentre noticias sobre su comunidad, entretenimiento, eventos locales y todo lo que desea saber del mundo del deporte y de sus equipos preferidos.

Ocasionalmente, puede recibir contenido promocional del Los Angeles Times en Español.